Mixture-of-Agents verbessert die Fähigkeiten von großen Sprachmodellen

Einleitung

In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs) erhebliche Fortschritte im Bereich des natürlichen Sprachverständnisses und der Textgenerierung gemacht. Trotz ihrer beeindruckenden Fähigkeiten stoßen diese Modelle jedoch an Grenzen bezüglich ihrer Größe und der Menge an Trainingsdaten. Hier setzt die Mixture-of-Agents (MoA) Methodik an, die die kollektive Expertise mehrerer LLMs nutzt, um deren Leistungsfähigkeit zu steigern. Dieser Artikel beleuchtet die Bedeutung der MoA-Methodik und ihre Vorteile gegenüber traditionellen Ansätzen.

Hintergrund zu großen Sprachmodellen

Große Sprachmodelle wie GPT-4 und LLaMA haben die Art und Weise revolutioniert, wie Computer natürliche Sprache verstehen und generieren. Diese Modelle sind auf riesigen Datenmengen vortrainiert und anschließend so abgestimmt, dass sie hilfreiche und kohärente Ausgaben erzeugen. Trotz dieser Fortschritte stehen sie vor Herausforderungen, wie den hohen Kosten für weiteres Skalieren und die Notwendigkeit umfangreicher Retrainings. Zudem besitzen verschiedene Modelle unterschiedliche Stärken, die es zu nutzen gilt.

Mixture-of-Agents Methodik

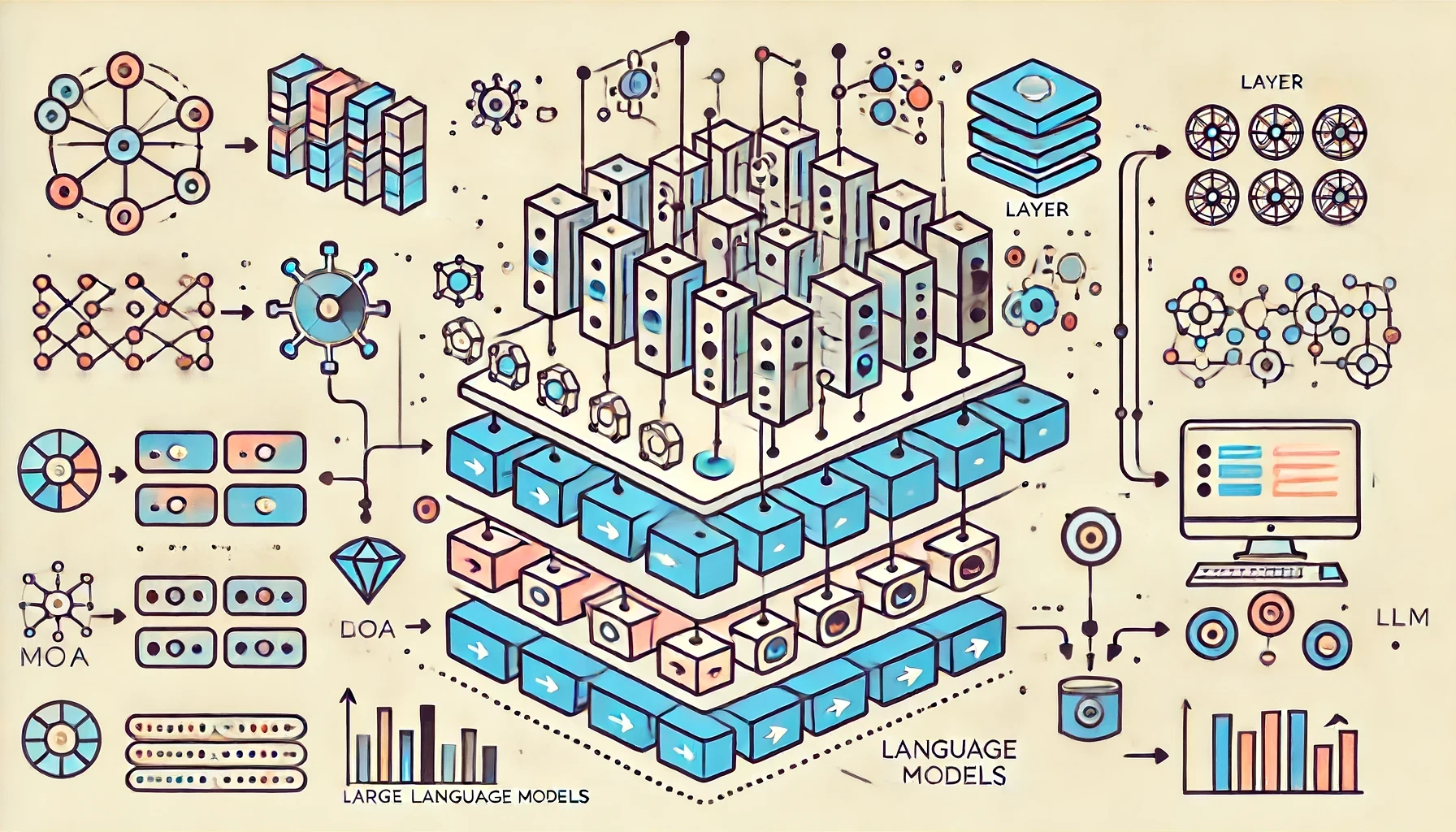

Die MoA-Methodik nutzt die kollektiven Stärken mehrerer LLMs durch eine mehrschichtige Architektur, in der jede Schicht aus mehreren LLM-Agenten besteht. Jeder Agent verarbeitet die Ausgaben der vorherigen Schicht und verbessert so iterativ die Qualität der generierten Antworten.

Kollaborativität von LLMs

LLMs neigen dazu, bessere Antworten zu generieren, wenn sie auf Ausgaben anderer Modelle zugreifen können. Diese Eigenschaft, als Kollaborativität bezeichnet, wird in der MoA-Methodik gezielt genutzt. Modelle werden in zwei Rollen unterteilt: Proposers, die nützliche Referenzantworten generieren, und Aggregators, die diese Antworten zu einer qualitativ hochwertigen Endantwort zusammenführen.

Design und Auswahl der Modelle

Für eine effektive Zusammenarbeit ist die sorgfältige Auswahl der Modelle in jeder MoA-Schicht entscheidend. Zwei Hauptkriterien leiten diesen Prozess: Leistungsmetriken und Diversitätsüberlegungen. Die Auswahl der Modelle basiert auf ihrer nachgewiesenen Leistung und der Vielfalt der generierten Antworten.

Detaillierte Evaluation von MoA

Um die Wirksamkeit der MoA-Methodik zu bewerten, wurden umfassende Tests mit den Benchmarks AlpacaEval 2.0, MT-Bench und FLASK durchgeführt.

Benchmark-Ergebnisse und Leistungsanalyse

Die MoA-Methodik zeigt signifikante Verbesserungen in der Antwortqualität und erreicht neue Spitzenwerte bei den getesteten Benchmarks. Besonders hervorzuheben ist die Leistungssteigerung gegenüber GPT-4 Omni.

Analyse der Mechanismen

Untersuchungen zeigen, dass die MoA-Methodik durch die iterative Zusammenarbeit der Agenten und die geschickte Nutzung diverser Modelle deutlich bessere Ergebnisse erzielt als herkömmliche Ansätze.

Kosten- und Effizienzanalysen

Die MoA-Methodik erweist sich nicht nur als leistungsfähiger, sondern auch als kosteneffizienter. Durch die parallele Verarbeitung und die geschickte Nutzung von Ressourcen kann die MoA-Methodik die Kosten im Vergleich zu anderen Modellen erheblich senken.

Verwandte Arbeiten

In der Forschung zu LLMs gibt es zahlreiche Ansätze zur Optimierung der Modellleistung. Dazu gehören Techniken wie das Chain of Thought (CoT) Prompting und Ensemble-Methoden, die mehrere Modelle kombinieren, um die besten Ergebnisse zu erzielen. Die MoA-Methodik erweitert diese Ansätze durch die Einführung einer strukturierten, mehrschichtigen Zusammenarbeit.

Fazit

Die Mixture-of-Agents-Methodik bietet einen innovativen Ansatz zur Nutzung der kollektiven Stärken mehrerer großer Sprachmodelle. Durch die iterative Zusammenarbeit und die gezielte Auswahl von Modellen erzielt die MoA-Methodik herausragende Ergebnisse in verschiedenen Benchmarks. Zukünftige Forschungen könnten die Optimierung der MoA-Architektur weiter vorantreiben und deren Anwendung in verschiedenen Bereichen untersuchen.

Wir laden Sie ein, sich an der Diskussion zu beteiligen. Teilen Sie Ihre Gedanken und Erfahrungen in den Kommentaren und in sozialen Netzwerken. Ihre Meinung ist wichtig, um die Zukunft dieser innovativen Technologie mitzugestalten. Lassen Sie uns gemeinsam die Möglichkeiten erkunden und nutzen!

Quelle: [2406.04692] Mixture-of-Agents Enhances Large Language Model Capabilities (arxiv.org)

Eine Antwort

[…] Agenten sind eine neue Art von KI-Modellen, die menschliches Verhalten und Entscheidungsprozesse simulieren […]