Kampf der KI Giganten: ChatGPT vs. Gemini im Duell

Die Welt der Künstlichen Intelligenz (KI) ist ein dynamisches und sich ständig weiterentwickelndes Feld, das regelmäßig bahnbrechende Innovationen hervorbringt. Zwei der neuesten und beeindruckendsten Beiträge in diesem Bereich sind ChatGPT 4 von OpenAI und Gemini ProVision von Google. Diese beiden KI-Modelle stehen an der Spitze der technologischen Fortschritte und bieten einzigartige Funktionen und Fähigkeiten, die sie von ihren Vorgängern unterscheiden. In diesem Artikel werden wir einen tieferen Einblick in beide Modelle geben, ihre Stärken und Schwächen analysieren und sie in einem direkten Vergleich gegenüberstellen. Unser Ziel ist es, ein umfassendes Bild davon zu vermitteln, wie ChatGPT 4 und Gemini ProVision die Landschaft der Künstlichen Intelligenz prägen und was ihre Entwicklung für die Zukunft der Technologie bedeutet.

Technischer Vergleich von ChatGPT4 und Gimini Pro Vision

Schauen wir uns zunächst die technischen Details der beiden Kontrahenten an.

| Kriterium | ChatGPT 4 | Gemini Pro Vision |

| Entwickler | OpenAI | Google (inkl. DeepMind) |

| Modelltyp | Multimodal, Large Language Model | Multimodal, Large Language Model |

| Eingabe | Text, Bilder | Text, Bilder, Videos |

| Ausgabe | Text | Text |

| Einführungsdatum | März 2023 | Dezember 2023 |

| Kontextfenster | 8,192 und 32,768 Tokens | 32,768 Tokens |

| Spezialisierungen | Textvorhersage, Menschliche Ausrichtung | Multimodale Aufgaben wie visuelles Verstehen, Klassifizierung, Zusammenfassung |

| Einsatzbereiche | Textvorhersage, Web-Suche, Bildgenerierung | Visuelle Informationsrecherche, Objekterkennung, digitales Content-Verständnis |

| Besondere Merkmale | Systemnachrichten für Tonauswahl und Aufgaben | Effiziente Ausführung auf einer Vielzahl von Systemen |

| Training | Zwei-Stufen-Training: Token-Vorhersage und Reinforcement Learning von menschlichem Feedback | Auf multimodalen und multilingualen Daten wie Webdokumenten, Büchern, Code und inklusive Bild-, Audio- und Videodaten trainiert |

| Bekannte Herausforderungen | Halluzinationen, mangelnde Transparenz in Entscheidungsprozessen | – |

Bitte beachten Sie, dass einige Details, insbesondere zu den technischen Spezifikationen von Gemini Pro Vision, nicht vollständig verfügbar sind. Die Informationen zu beiden Systemen basieren auf den aktuell verfügbaren Quellen.

Der Umfassende Frage-Antwort-Test

In unserem umfangreichen Test haben wir die beiden Konkurrenten gegeneinander antreten lassen. Das Ergebnis ist eindeutig, wenn auch knapp.

| Fragekategorie | Beispiele | ChatGPT4 | GEMINI Pro Vision |

| Verständnis von Kontext und Nuancen | Was bedeutet der Ausdruck “Auf Wolke sieben schweben”? | Ok | Ok |

| Was bedeutet “jemandem die Daumen drücken”? | Ok | Ok | |

| Was bedeutet es, wenn jemand “kein Blatt vor den Mund nimmt”? | Ok | Ok | |

| Was bedeutet “den Faden verlieren”? | Ok | Ok | |

| Erzeugung kreativer Inhalte | Kannst du ein Gedicht über den Frühling schreiben? | Ok | Ok |

| Kannst du die Schritte zum Kochen von Risotto erklären? | Ok | FALSCH | |

| Gebe einen Namensvorschlag für einen altdeutschen Namen. | Ok | Ok | |

| Fähigkeit, auf aktuelle Ereignisse zu reagieren | Wer ist 2023 Bundeskanlzer gewesen? | Ok | FALSCH |

| Welche Mannschaft gewann die Weltmeisterschaft im Fußball 2022 | Ok | Ok | |

| Welche Wirtschaftsordnung hat die Bundesrepublik Deutschland? | Ok | Ok | |

| Fähigkeit, komplexe Anfragen zu bearbeiten (Logik) | Ich habe T-Shirts gewaschen. Ein T-Shirt braucht in der Sonne 2 Stunden um zu trocknen. Wie lange brauchen 5 T-Shirts? | Ok (++) | Ok (++) |

| Michael, Marie und Jens treten in einem sportlichen Wettkampf gegeneinander an. Die Frage ist, wer ist am schnellsten? Michael ist schneller als Jens, Marie ist schneller als Michael. Wer ist am schnellsten? | Ok | Ok | |

| Ergänze die Buchstabenfolgen. A C E G I K M ? | FALSCH | Ok | |

| Ergänze die Buchstabenfolgen. D C A B H G E F ? | FALSCH | FALSCH | |

| Mathematik | Wurzel aus 3. | Ok | Ok |

| 100+20-6*5(5-2) | Ok | Ok | |

| 3^2+4-6^(4-2)-5 | Ok | Ok | |

| Programmierung | Erstelle ein Python Script, dass die Zahlen von 0 bis 100 ausgibt. | Ok | Ok |

| Erstelle ein Programm in Python, dass einen Raketenstart mit einen Countdown von 10 abwärtst zählt. Die Zahlen sollen jede Sekunde ausgegeben werden. | Ok | Ok | |

| Erstelle ein Spiel in Python nach dem Vorbild des Klassikers “Snake”. | Ok | FALSCH | |

| Anzahl richtiger Antworten | 17 | 15 | |

| Prozent | 85% | 75% |

Von 20 möglichen Punkten hat ChatGPT 4 genau 17 Fragen richtig beantwortet. Insbesondere bei den Logikrätseln machte ChatGPT erstaunlich viele Fehler. Dies zeigt auch die derzeitigen Grenzen der verschiedenen Modelle. Überraschend war jedoch Gemini. Bei den Logikrätseln konnte Gimini eine Frage mehr richtig beantworten.

Die Frage nach dem Bundeskanzler in Deutschland im Jahr 2023 wurde von Gimini mit Verweis auf den Datenstand von 2021 verneint. Überraschenderweise konnte er aber den Gewinner der Fußball-Weltmeisterschaft 2022 korrekt nennen.

Die Antwort auf die Frage nach einem Risotto-Rezept ist natürlich Geschmackssache, aber insbesondere die Menge des Olivenöls sowie des Knoblauchs wäre stark übertrieben.

Hinweise zum Test:

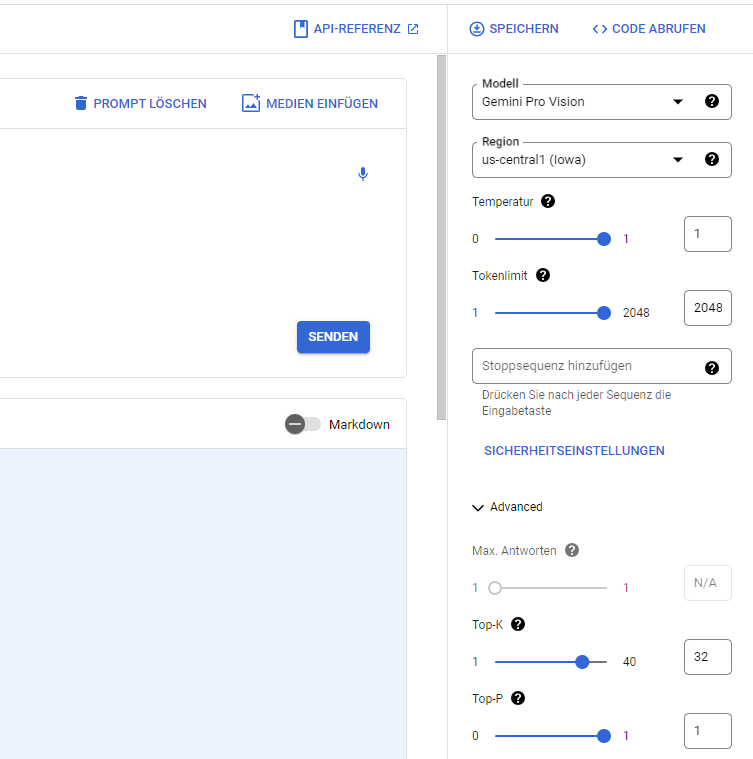

ChatGPT4 wurde direkt in der WebUI verwendet. Weitere Einstellmöglichkeiten sind nicht möglich (z.B. Temperatur, Tokenanzahl etc.). Gimini wurde in der Google Cloud Vertex AI verwendet. Dies ähnelt dem Playground von OpenAI. Die Einstellungen wurden bis auf die Temperatur (1) auf die voreinstellungen gelassen.

Eine spannende Möglichkeit kann derzeit nicht aktiviert werden:

Durch die Option Fundierung könnten Antworten in der Zukunft “sicherer” und valider werden.

Zusammenfassung

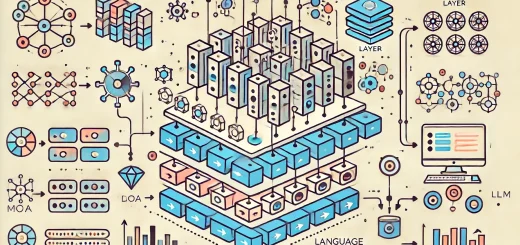

In der Welt der künstlichen Intelligenz zeichnen sich sowohl ChatGPT 4 als auch Gemini als Multimodal Large Language Models aus, die nicht nur Text und Bilder, sondern im Falle von Gemini auch Videos mit Bravour verarbeiten. ChatGPT 4, das im Frühling des Jahres 2023 sein Debüt feierte, brilliert mit der Fähigkeit, zwischen zwei Kontextfenstern zu wechseln – eine Flexibilität, die es von Gemini unterscheidet, das gegen Ende desselben Jahres mit einem einzigen, großzügigeren Kontextfenster auf den Markt kam.

Während ChatGPT 4 seine Stärken in der Textvorhersage und einer ausgeprägten Ausrichtung auf menschliche Interaktionen findet, beweist Gemini seine Finesse in der Bewältigung visueller Herausforderungen und der Verarbeitung von Informationen. Die Schulung von ChatGPT 4 umfasste einen zweistufigen Prozess, der von menschlicher Interaktion geprägt ist, im Gegensatz zu Gemini, das sein Wissen aus einer reichen Vielfalt von multimodalen und multilingualen Daten schöpft.

Eine eingehende Analyse in Form eines Frage-Antwort-Tests offenbarte, dass ChatGPT 4 mit einer Punktzahl von 85% die Nase vorn hatte, dicht gefolgt von Gemini mit 75%. Obwohl ChatGPT 4 bei einigen Logikaufgaben strauchelte, zeigte Gemini in diesem Bereich besondere Stärke und übertraf seinen Konkurrenten in einem Logikrätsel. Trotz eines Fehltritts bei der Identifikation des deutschen Bundeskanzlers von 2023 – ein Fehler, der aus der Anlehnung an Daten von 2021 resultierte – verblüffte Gemini mit der korrekten Benennung des Fußballweltmeisters von 2022.

Weitere spannende Test von verschiedenen Modellen werden folgen. Hier finden Sie die Gesamtübersicht!

Hätten Sie an das Ergebnis geglaubt? Womit hätten sie gerechnet? Diskutieren Sie diesen Artikel in den Kommentaren und auf den sozialen Netzwerken!

2 Antworten

[…] Weitere spannede Artikel zum Thema gibt es hier. […]

[…] Neuerungen von OpenAI in Bezug auf synthetische Stimmen und den vereinfachten Zugang zu ChatGPT sind mehr als nur technische Errungenschaften; sie sind ein Vorbote für die Art und Weise, wie wir […]