Du glaubst, dein KI-Chatbot liegt richtig? Diese Uni beweist das Gegenteil

Mit CheckMate stellt Cambridge eine offene Plattform vor, die KI-Sprachmodelle erstmals interaktiv bewertet – durch echtes Nutzerfeedback auf mathematische Aufgaben. Die Ergebnisse zeigen: Große Sprachmodelle wie GPT-4 wirken oft korrekt, täuschen aber gefährlich regelmäßig daneben.

Inhaltsübersicht

Einleitung

Warum wir KI-Fehler für Wahrheiten halten – und wie CheckMate das entlarvt

Architektur hinter CheckMate: Wie Nutzerfeedback strukturiert die KI entlarvt

Wenn korrekt falsch ist: Warum KI-Ergebnisse nicht nur plausibel, sondern verlässlich sein müssen

Fazit

Einleitung

Große Sprachmodelle wie ChatGPT oder GPT-4 scheinen auf den ersten Blick erstaunlich kompetent. Aber was, wenn sie sich überzeugend irren – und du es nicht bemerkst? Genau dieses Problem nimmt sich die neue Open-Source-Plattform CheckMate der University of Cambridge vor. Sie erlaubt es Nutzern, Antworten eines KI-Modells auf mathematische Fragen zu bewerten – hinsichtlich Korrektheit und Hilfsbereitschaft. Die Plattform geht damit über klassische Benchmark-Tests hinaus und bezieht echte menschliche Einschätzungen ein. Die begleitende Studie, veröffentlicht in den renommierten *Proceedings of the National Academy of Sciences*, offenbart ein alarmierendes Ergebnis: LLMs produzieren nicht nur Fehler, diese werden oft nicht als solche erkannt. Das Forschungsteam sieht darin ein echtes Risiko – gerade in Anwendungsfeldern, in denen Nutzer wenig Fachwissen oder kritisches Hinterfragen mitbringen.

Warum wir KI-Fehler für Wahrheiten halten – und wie CheckMate das entlarvt

CheckMate von der University of Cambridge ist mehr als nur ein weiteres Tool zur KI-Bewertung. Die Plattform konfrontiert eine zentrale Schwachstelle heutiger Sprachmodelle wie GPT-4: Ihre Fähigkeit, überzeugend zu klingen – auch wenn sie danebenliegen. Dabei setzt CheckMate nicht auf automatisierte Metriken, sondern auf Menschen, die urteilen.

Genauer gesagt: Auf 25 Mathematikerinnen und Mathematiker, die Antworten der LLMs zu Aufgaben aus der Hochschulmathematik einordnen. Die Fachleute bewerten anonym, ob eine KI-Antwort sachlich korrekt und hilfreich ist. Das Entscheidende: CheckMate nimmt nicht nur das Urteil auf, sondern erfasst auch, wie sicher sich die Nutzer dabei fühlen. Die Plattform untersucht, wie oft fehlerhafte Aussagen trotzdem als richtig empfunden werden – ein zentrales Risiko bei Sprachmodellen, die immer souverän klingen.

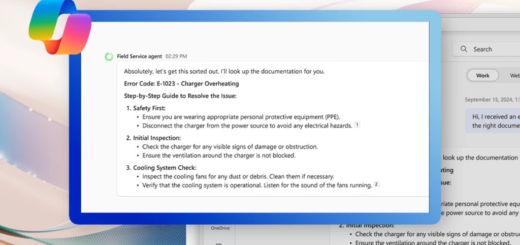

Im Gegensatz zu bisherigen Ansätzen, bei denen meist einzelne Benchmarks oder Rating-Sternchen zählen, erlaubt CheckMate eine interaktive Bewertung. Nutzer sehen verschiedene plausible KI-Antworten nebeneinander, vergleichen, kommentieren – und geben so ein differenziertes LLM Feedback. Genau daraus entsteht ein datengestütztes Bild von typischen Fehlermustern.

Die Cambridge Studie zeigt deutlich: Wir überschätzen oft die Korrektheit künstlicher Intelligenz, insbesondere wenn wir uns selbst nicht ganz sicher sind. Durch den Vergleich von Nutzerfeedback und objektiv richtiger Lösung hat CheckMate ein Instrument geschaffen, das Fehlererkennung in KI-Systemen nicht nur sichtbar macht, sondern erklärbar. Für den künftigen Aufbau vertrauenswürdiger KI ist das ein überfälliger Schritt.

Architektur hinter CheckMate: Wie Nutzerfeedback strukturiert die KI entlarvt

CheckMate ist mehr als nur eine Bewertungsplattform – sie ist eine präzise konstruierte Testumgebung, die große Sprachmodelle wie GPT-4 unter kontrollierten Bedingungen herausfordert. Im Kern kombiniert sie moderne Webtechnologien mit einer modularen Systemarchitektur, die Interaktionen zwischen Nutzern und KI-Outputs erfassbar und auswertbar macht. Entwickelt wurde die Plattform von einem interdisziplinären Team der University of Cambridge, das Expertinnen und Experten aus Mathematik, Informatik, Ingenieurwissenschaften und Kognitionspsychologie vereinte.

Die Benutzeroberfläche stellt Prüffragen auf Bachelor-Niveau aus der Mathematik, gefolgt von Antworten verschiedener LLMs wie ChatGPT oder InstructGPT. Nutzer – darunter im Studienaufbau 25 Mathematiker – bewerten anonym und unabhängig, ob die Antwort korrekt und hilfreich war. Zusätzlich geben sie an, wie sicher sie sich dabei sind. Diese Angaben zur Selbstsicherheit sind essenziell, um herauszufinden, wann Menschen sich von plausiblen – aber falschen – Antworten täuschen lassen.

Im Backend werden all diese Daten strukturiert erfasst: jede Bewertung wird in Beziehung gesetzt zur Modellquelle, zur Nutzerunsicherheit und zur faktischen Antwortqualität. Daraus entsteht ein komplexes Feedback-Netzwerk, das differenziert zeigt, wie Fehlererkennung bei KI scheitern oder funktionieren kann. Die größte Herausforderung? Die subjektiven Einschätzungen der Menschen in messbare Qualität zu übersetzen – ein Prozess, der konstant interdisziplinär nachjustiert wurde.

Besonders relevant: CheckMate analysiert, wie KI-Systeme mit Unsicherheit umgehen – oder eben nicht. Dadurch trägt die Plattform aktiv zur Entwicklung vertrauenswürdiger KI bei. Ein Werkzeug, das gängige Annahmen über die Verlässlichkeit von LLM Feedback auf den Prüfstand stellt – und zwar messbar, reproduzierbar und offen zugänglich.

Wenn korrekt falsch ist: Warum KI-Ergebnisse nicht nur plausibel, sondern verlässlich sein müssen

Das wohl brisanteste Ergebnis der Cambridge Studie: Large Language Models wie GPT-4 liefern oft Antworten, die auf den ersten Blick richtig wirken – es aber schlicht nicht sind. Besonders problematisch wird’s, wenn Nutzer unbemerkt falsche Aussagen übernehmen, gerade in Kontexten mit hoher fachlicher Komplexität. CheckMate, die Open-Source-Plattform der University of Cambridge, zeigt genau das: Selbst versierte Mathematiker ließen sich in Interaktiven KI-Tests häufiger täuschen, als ihnen lieb war.

Das stellt die Vertrauenswürdigkeit von KI-Systemen grundsätzlich in Frage. Denn was nützt eine eloquent erklärte Lösung, wenn sie im Kern fehlerhaft ist – und niemand merkt’s? Die Fehlererkennung von KI wird damit zur Schlüsselfrage. Nutzer können auf Basis der CheckMate-Daten erstmals nachvollziehen, wie oft KI-Antworten falsch bewertet werden – und warum.

Besonders erhellend: Die Unsicherheitskommunikation fehlt fast vollständig. Wenige bis keine Hinweise darauf, wie sicher sich das Modell ist. Für künftige Systeme ist das ein Muss. Transparente Hinweise auf Antwortkonfidenz und Feedback-Mechanismen wie bei CheckMate schaffen nicht nur Bewusstsein, sondern auch dringend nötige Korrekturpotenziale.

Was daraus folgt? Der Ansatz der KI-Bewertung über nutzerbasiertes LLM Feedback könnte zum Standard werden – nicht nur in der Forschung, sondern auch in industriellen Anwendungen, im Bildungsbereich oder in KI-unterstützter Lehre. Die Vision: Systeme, die eigene Grenzen erkennen und mitteilen können.

Die Technik kann komplex rechnen – aber ohne Selbstreflexion bleibt sie gefährlich überzeugend.

Fazit

CheckMate rückt eine bisher kaum beachtete Schwäche aktueller KI-Modelle ins Rampenlicht: Ihre Fähigkeit, überzeugend falsche Antworten zu geben – und Nutzer so aktiv in die Irre zu führen. Die Plattform zeigt, dass Vertrauen und Korrektheit nicht dasselbe sind. Mehr noch: Sie liefert erstmals ein Werkzeug, mit dem solche Unterschiede systematisch analysiert werden können. Für Entwickler großer Sprachmodelle eröffnet das eine neue Qualität der Qualitätskontrolle – ergänzt durch echtes Nutzerfeedback. Angesichts der wachsenden Nutzung von LLMs in Bildung, Forschung und Industrie könnte CheckMate richtungsweisend dabei helfen, KI-Systeme transparenter, sicherer und letztlich glaubwürdiger zu gestalten.

Teile diesen Artikel mit Kollegen oder Freunden, die täglich mit KI arbeiten – sie könnten überrascht sein, wie oft ihre Tools falschliegen.

Quellen

New open-source platform allows users to evaluate AI-powered chatbots

Evaluating language models for mathematics through interactive human feedback (PNAS)

Evaluating language models for mathematics through interactive human feedback

DSP_LLMs_Stanford_2024 (LinkedIn)

Efficient and Scalable Large Multimodal Models (Berkeley Tech Report)

The role of uncertainty communication in trustworthy AI systems (PNAS)

Program – ISPOR 2025

Cybersecurity Governance and Normative Frameworks (CCDCOE)

Application Security Testing Solutions | Microminder CS

Junting-Lu/Awesome-LLM-Reasoning-Techniques (GitHub)

Hinweis: Dieser Artikel wurde mit Unterstützung von KI erstellt.