Die Ära der KI wird durch 1-Bit Large Language Models neu definiert. Eine Analyse von BitNet b1.58 zeigt die Fortschritte und Auswirkungen dieser Modelle.

Die rasante Entwicklung im Bereich der künstlichen Intelligenz, insbesondere bei Large Language Models (LLMs), stellt neue Anforderungen an Effizienz und Leistung. Vor diesem Hintergrund markiert die Einführung von 1-Bit LLMs, wie BitNet b1.58, einen wichtigen Meilenstein, der das Potenzial hat, diese Herausforderungen zu bewältigen.

Hintergrund zur Entwicklung von 1-Bit Large Language Models

Traditionelle LLMs, die auf 16-Bit Fließkommaeinheiten basieren, haben ihren Platz in einer Vielzahl von Anwendungen bewiesen, stoßen jedoch in Bezug auf Energieverbrauch und Speichereffizienz an ihre Grenzen. Die Notwendigkeit, diese Modelle zu optimieren, führte zur Entwicklung von BitNet b1.58.

Technische Spezifikationen von BitNet b1.58

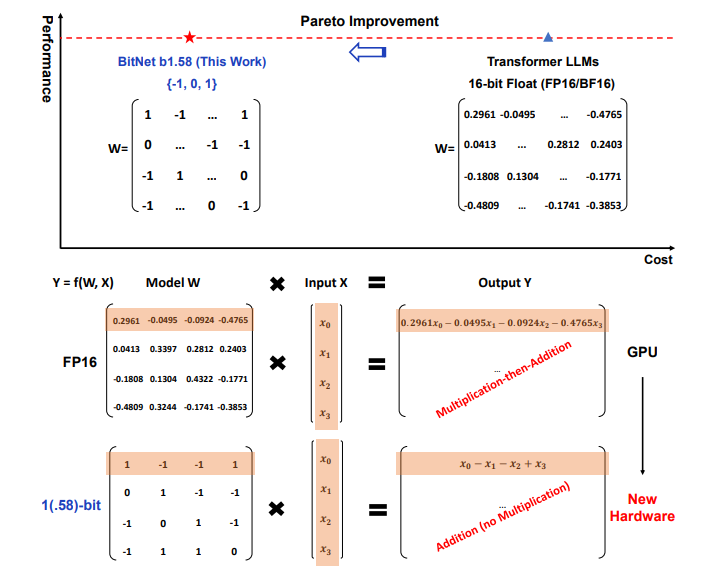

BitNet b1.58 revolutioniert das Konzept der LLMs durch die Einführung einer ternären Parametercodierung {-1, 0, 1}, die es ermöglicht, die Modelleffizienz erheblich zu steigern, ohne die Leistung zu beeinträchtigen. Diese Änderung ermöglicht eine deutliche Reduzierung der Latenz, des Speicherverbrauchs und des Energiebedarfs.

Leistungsanalyse von 1-Bit Large Language Models

BitNet b1.58 zeigt im Vergleich zu traditionellen LLMs und anderen 1-Bit Modellen beeindruckende Ergebnisse in Bezug auf Perplexität und End-to-End-Leistung. Diese Verbesserungen erstrecken sich auch auf die Durchlaufzeit, den GPU-Speicher und die Latenz, wobei BitNet b1.58 insbesondere bei größeren Modellgrößen Vorteile bietet.

Anwendungsfälle und Vorteile von 1-Bit Large Language Models

Die Effizienz von BitNet b1.58 eröffnet neue Möglichkeiten für den Einsatz in ressourcenbeschränkten Umgebungen wie Edge- und Mobilgeräten und ermöglicht eine breitere Anwendung von LLMs in der Praxis.

Zukünftige Forschungsrichtungen

Die Entwicklung von 1-Bit LLMs steht noch am Anfang. Zukünftige Forschungen könnten sich auf die Weiterentwicklung der Modellarchitekturen, die Anpassung an spezifische Hardwareanforderungen und die Erweiterung der Anwendungsfälle konzentrieren.

Fazit

BitNet b1.58 stellt einen bedeutenden Fortschritt in der Entwicklung von LLMs dar, der nicht nur die Leistungsfähigkeit und Effizienz dieser Modelle verbessert, sondern auch neue Wege für deren Anwendung eröffnet. Die Fortsetzung dieser Forschungsrichtung verspricht spannende Entwicklungen für die Zukunft der künstlichen Intelligenz.

Quelle:

[2402.17764] The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits (arxiv.org)

Wir laden Sie ein, sich an der Diskussion zu beteiligen. Teilen Sie Ihre Gedanken und Erfahrungen in den Kommentaren und in sozialen Netzwerken. Ihre Meinung ist wichtig, um die Zukunft dieser innovativen Technologie mitzugestalten. Lassen Sie uns gemeinsam die Möglichkeiten erkunden und nutzen!