Autogen – jetzt auch mit lokalen LLMs kostenlos nutzen und Datensicherheit garantieren

AutoGen: Ein Framework für die Entwicklung von LLM-Anwendungen

AutoGen ist ein Framework, das die Entwicklung von LLM-Anwendungen mit mehreren Agenten ermöglicht. Diese Agenten können miteinander sprechen, um Aufgaben zu lösen. AutoGen-Agenten sind anpassbar und ermöglichen nahtlos menschliche Teilnahme. Sie können in verschiedenen Modi arbeiten, die Kombinationen von LLMs, menschlichen Eingaben und Tools verwenden.

Multi-Agenten-Gespräche

AutoGen ermöglicht den Aufbau von LLM-Anwendungen der nächsten Generation auf der Grundlage von Multi-Agenten-Gesprächen mit minimalem Aufwand. Es vereinfacht die Orchestrierung, Automatisierung und Optimierung eines komplexen LLM-Workflows. Es maximiert die Leistung von LLM-Modellen und überwindet ihre Schwächen.

Anpassbare Agenten

AutoGen unterstützt verschiedene Gesprächsmuster für komplexe Workflows. Mit anpassbaren Agenten können Entwickler AutoGen verwenden, um eine Vielzahl von Gesprächsmustern in Bezug auf Gesprächsautonomie, Anzahl der Agenten und Agentengesprächstopologie zu erstellen.

Weitere Informationen

Wenn Sie mehr über AutoGen erfahren möchten, besuchen Sie bitte die offizielle Website oder das GitHub-Repository.

Ich hoffe, dass ich Ihnen mit diesem Text weiterhelfen konnte. Wenn Sie weitere Fragen haben, stehe ich Ihnen gerne zur Verfügung.

Vorteile der Verwendung lokaler LLMs

Die Verwendung lokaler Large Language Models (LLMs) kann im Vergleich zur Verwendung der OpenAI API Kosten sparen, da nach der anfänglichen Investition in die erforderliche Hard- und Software und der Einrichtung des Systems keine wiederkehrenden Gebühren für API-Aufrufe anfallen.

Dies ist insbesondere bei einem hohen Anfragevolumen von Vorteil, da die Kosten der OpenAI API nutzungsabhängig sind und mit der Anzahl der Anfragen steigen. Lokale Modelle bieten zudem die Möglichkeit der Anpassung und Optimierung für spezifische Anwendungsfälle, was langfristig zu einer effizienteren Nutzung und damit zu Kosteneinsparungen führen kann.

Darüber hinaus werden durch das Hosting des Modells vor Ort Datenübertragungskosten minimiert und Latenzzeiten reduziert, was wiederum die Gesamteffizienz erhöht und Kosten spart. Insbesondere bei sensiblen Daten ist es von Vorteil, wenn diese das eigene Netzwerk nicht verlassen.

Nachteile lokaler LLMs

Die Investitionskosten in geeignete Hardware können schnell mehrere tausend Euro betragen. Insbesondere bei großen Sprachmodellen ist entsprechend leistungsfähige Hardware erforderlich. Daher sollte eine sorgfältige Kosten-Nutzen-Abwägung erfolgen.

Autogen mit lokalen LLMs – eine mögliche Variante

Es wird vorausgesetzt, dass Sie bereits Python, Autogen und ggf. einen Editor wie Visual Studio Code installiert haben.

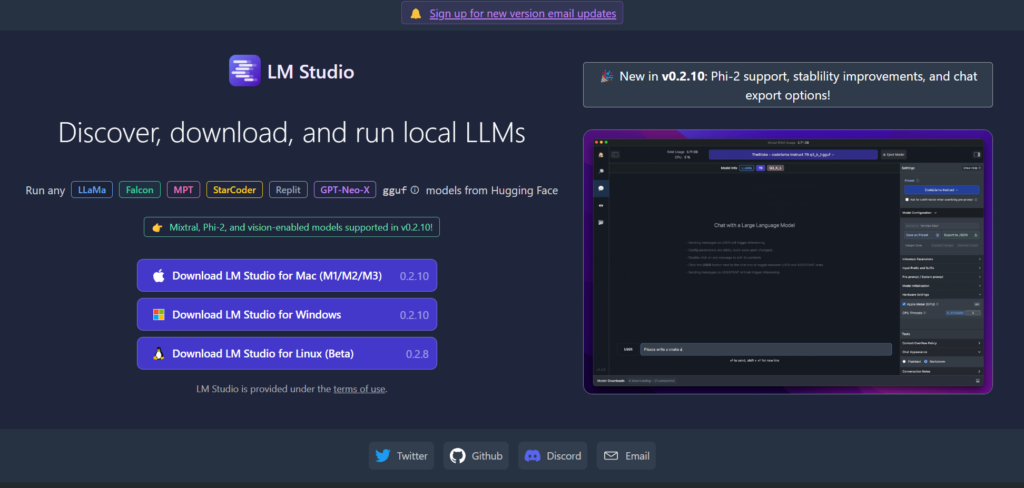

Zunächst müssen wir ein LLM auf unserer Hardware installieren und diese für Autogen ansprechbar machen. Eine einfache Möglichkeit ist die Verwendung von LM Studio.

Nach der Installation von LM Studio können Sie ein passendes Modell in der App downloaden und konfigurieren Sie es entsprechend den jeweiligen Anforderungen. Dies beinhaltet das Einstellen von Parametern wie Speicherlimits und Antwortzeiten, die für Ihre Anwendung optimiert sind.

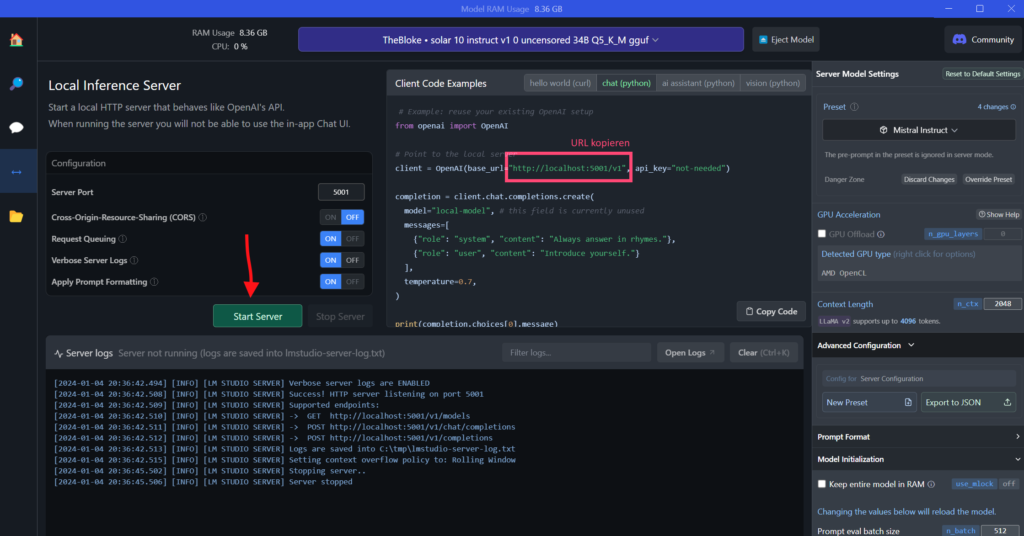

Als nächstes richten Sie Autogen so ein, dass es mit LM Studio kommunizieren kann, indem Sie die entsprechende API oder Schnittstelle einrichten, die von LM Studio zur Verfügung gestellt wird. Starten Sie dafür den Server-Modus in LM Studio und kopieren Sie die URL, um diese in Autogen im nächsten Schritt einzutragen.

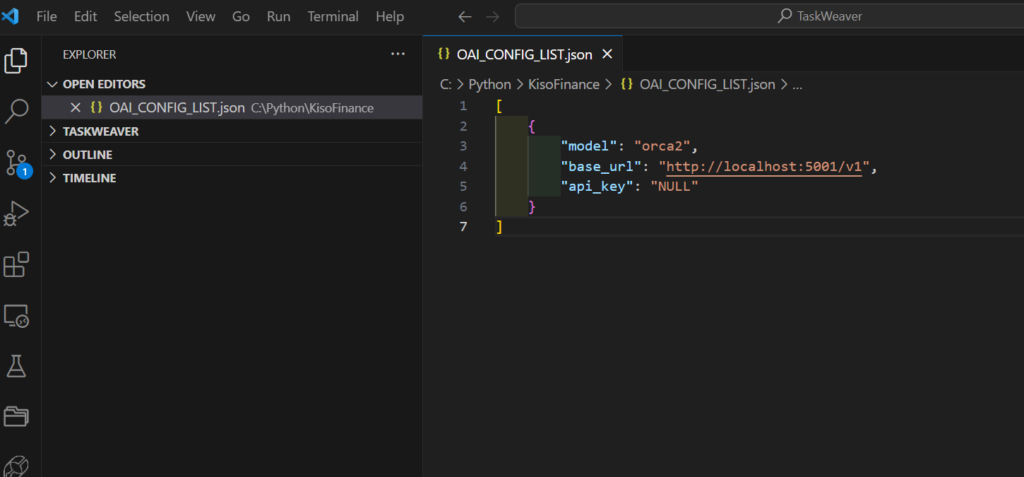

In Autogen kann dann in der Config-List das Model eingetragen werden. Wichtig ist dabei die base_url, die Felder model und api_key sind zunächst frei wählbar. Es können mehrere Models eingetragen werden, so kann man ggf. auch kostenpflichtige APIs mit lokalen LLMs kombinieren.

Sobald die Einrichtung abgeschlossen ist, können Sie beginnen, Skripte oder Programme zu entwickeln, die Autogen verwenden, um Aufgaben wie Code-Generierung, Textautomatisierung oder andere komplexe Aufgaben, die LLMs nutzen, zu automatisieren.

Sie haben nun die volle Kontrolle und Flexibilität über das Large Language Model und können Änderungen vornehmen, aktualisieren oder optimieren, wie es für Ihre speziellen Bedürfnisse nötig ist. Mit einer lokalen LLM-Implementierung können Sie auch sicherstellen, dass sensible Daten intern bleiben und die Gesamtbetriebskosten langfristig senken, während Sie von den leistungsstarken Funktionen der Large Language Models profitieren.

Starten Sie jetzt in die aufregende Welt autonomer Agenten!